小编给大家分享一下Java如何使用httpRequest+Jsoup爬取红蓝球号码,希望大家阅读完这篇文章之后都有所收获,下面让我们一起去探讨吧!

1、Jsoup介绍

1.1、简介

jsoup 是一款Java 的HTML解析器,可直接解析某个URL地址、HTML文本内容。它提供了一套非常省力的API,可通过DOM,CSS以及类似于jQuery的操作方法来取出和操作数据。

1.2、Jsoup的主要功能

从一个URL,文件或字符串中解析HTML

2、使用DOM或CSS选择器来查找、取出数据

3、可操作HTML元素、属性、文本

注意:jsoup是基于MIT协议发布的,可放心使用于商业项目。

2、源网站及页面元素分析

2.1、号码源

首先,这里我选择近年来比较稳定的数据源地址【某网站】截图如下

2.2、dom元素分析

2.1、开奖号码主体分析

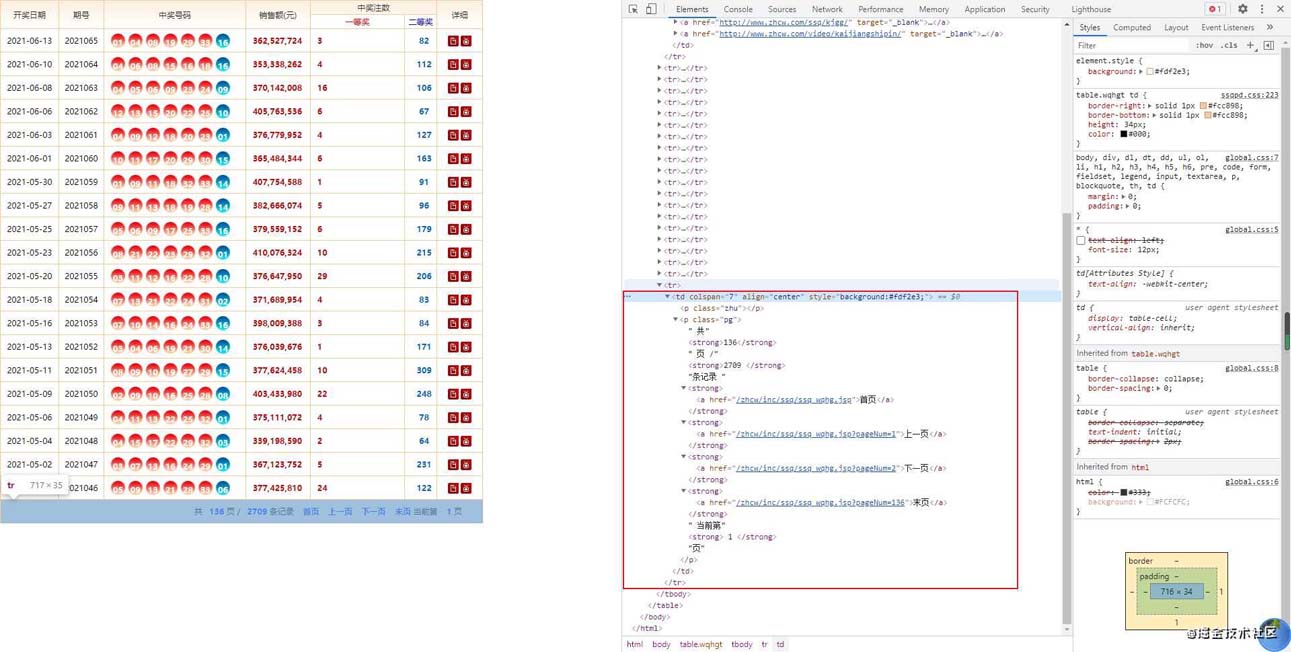

先打开开发者工具,找到每条开奖号码对应的dom元素

可以看到每一期号码信息主体在一个<tr>标签中,其中第一个<td>是开奖日期,第二个<td>是开奖期号,第三个<td>是开奖号码,每个奖号是单独的标签,红球的class=rr,篮球没有设置样式

<tr> <td align="center">2021-06-13</td> <td align="center">2021065</td> <td align="center" > <em class="rr">01</em> <em class="rr">04</em> <em class="rr">08</em> <em class="rr">19</em> <em class="rr">29</em> <em class="rr">33</em> <em>16</em></td> <td><strong>362,527,724</strong></td> <td align="left" ><strong>3</strong></td> <td align="center"><strong class="rc">82</strong></td> <td align="center"> <a href="http://www.zhcw.com/ssq/kjgg/" rel="external nofollow" target="_blank"><img src="http://images.zhcw.com/zhcw2010/kaijiang/zhcw/ssqpd_42.jpg" width="16" height="16" align="absmiddle" title="详细信息"></a> <a href="http://www.zhcw.com/video/kaijiangshipin/" rel="external nofollow" target="_blank"><img src="http://images.zhcw.com/zhcw2010/kaijiang/zhcw/ssqpd_43.jpg" width="16" height="16" align="absmiddle" title="开奖视频"></a> </td> </tr>2.2、页码区域分析

由于我们爬取数据的时候,需要进行翻页操作,所以这里还需要分析翻页部分的内容,继续在开发者工具中,定位页码区域

可以看到页码部分是<tbody>中的最后一个<tr>中,翻页操作的内容再class=pg的 <p> 标签中

可以拆分为多个<storage>标签数组,可以分析得出翻页链接的规律。

/zhcw/inc/ssq/ssq_wqhg.jsp?pageNum=页码

或

/zhcw/html/ssq/list_页码.html

| 元素 | 含义 |

|---|---|

| 0 | 总页数 |

| 1 | 总记录数 |

| 2 | 第一页的连接 |

| 3 | 上一页的链接 |

| 4 | 下一页的链接 |

| 5 | 最后一页的连接 |

| 6 | 当前页数 |

<tr> <td colspan="7" align="center" > <p class="zhu"></p> <p class="pg"> 共<strong>136</strong> 页 /<strong>2709 </strong>条记录 <strong><a href="/zhcw/inc/ssq/ssq_wqhg.jsp" rel="external nofollow" >首页</a></strong> <strong><a href="/zhcw/inc/ssq/ssq_wqhg.jsp?pageNum=1" rel="external nofollow" >上一页</a></strong> <strong><a href="/zhcw/inc/ssq/ssq_wqhg.jsp?pageNum=2" rel="external nofollow" >下一页</a></strong> <strong><a href="/zhcw/inc/ssq/ssq_wqhg.jsp?pageNum=136" rel="external nofollow" >末页</a></strong> 当前第<strong> 1 </strong>页</p> </td> </tr>3、代码实现

maven引用,这里使用的是Jsoup1.13.1版本

<dependency> <groupId>org.jsoup</groupId> <artifactId>jsoup</artifactId> <version>1.13.1</version> </dependency>这使用的是基于jeecg开发的Job,搭建过程不赘述了,直接看主体代码。

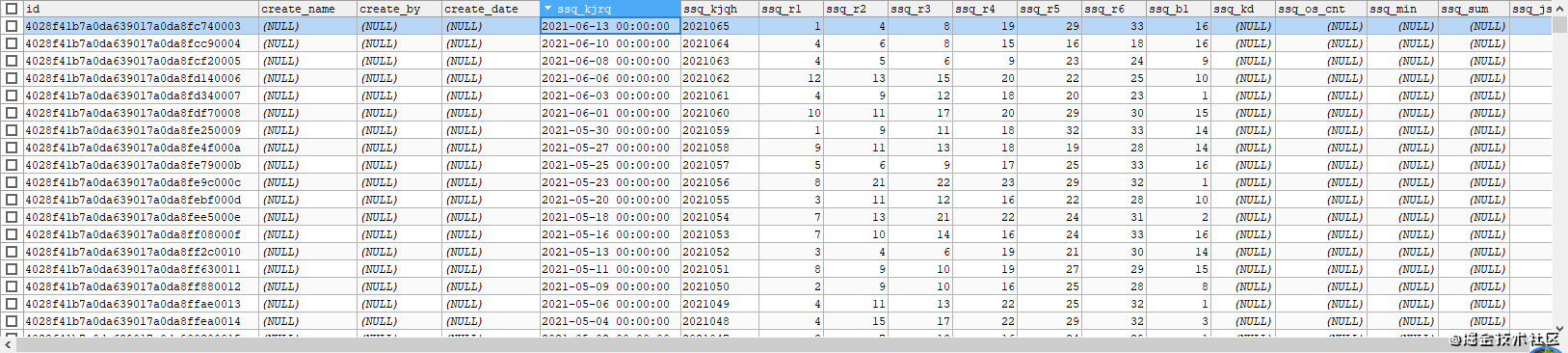

public void execute(JobExecutionContext arg0) throws JobExecutionException { Integer maxPage=getMaxPage();//获取总页数 for(int pageNo=0;pageNo<maxPage;pageNo++){//循环处理每一页的数据 String url = "http://kaijiang.zhcw.com/zhcw/html/ssq/list_"+(pageNo+1)+".html";//拼访问地址 String strDateFormat = "yyyy-MM-dd"; SimpleDateFormat sdf = new SimpleDateFormat(strDateFormat); String html = JwtHttpUtil.httpRequest(url, "GET",null);//访问对应的页面 Document doc = Jsoup.parse(html);//用Jsoup解析页面内容并且解析为Document Document doc1= Jsoup.parse(doc.getElementsByClass("wqhgt").toString());//wqhgt是table标签的class,这里获取到开奖号码的table的内容并且解析为Document Elements trs= doc1.getElementsByTag("tr");//根据tag获取到所有的tr标签,这里获取到的是一个Element数组 logger.info("当前页码---"+(pageNo+1)+"----"+trs.size()); for(int i=2;i<trs.size()-1;i++){//这里是根据页面内容确定开奖内容是从第三个tr开始到倒数第二个tr结束,最后一个tr是翻页按钮 try { Elements tds=trs.get(i).getElementsByTag("td"); String kjrq=tds.get(0).text(); String kjqh=tds.get(1).text(); //这里是为了防止重复拉取,所以做了判断,如果已存在当前期的奖号,就直接跳过 Long count=lotterySsqKjjlService.getCountForJdbc("select count(*) from lottery_ssq_kjjl where SSQ_KJQH='"+ kjqh + "'"); //下面的内容很容易理解,就是可以对照页面分析部分内容看,就不赘述了 if(count>0)break; LotterySsqKjjlEntity kjhmEntiry=new LotterySsqKjjlEntity(); Elements kjhm=tds.get(2).getElementsByTag("em"); kjhmEntiry.setSsqKjrq(sdf.parse(kjrq)); kjhmEntiry.setSsqKjqh(kjqh); kjhmEntiry.setSsqR1(Integer.parseInt(kjhm.get(0).text())); kjhmEntiry.setSsqR2(Integer.parseInt(kjhm.get(1).text())); kjhmEntiry.setSsqR3(Integer.parseInt(kjhm.get(2).text())); kjhmEntiry.setSsqR4(Integer.parseInt(kjhm.get(3).text())); kjhmEntiry.setSsqR5(Integer.parseInt(kjhm.get(4).text())); kjhmEntiry.setSsqR6(Integer.parseInt(kjhm.get(5).text())); kjhmEntiry.setSsqB1(Integer.parseInt(kjhm.get(6).text())); lotterySsqKjjlService.save(kjhmEntiry); } catch (ParseException e) { // TODO Auto-generated catch block e.printStackTrace(); } catch (Exception e) { // TODO Auto-generated catch block e.printStackTrace(); } } } } private Integer getMaxPage(){ String url = "http://kaijiang.zhcw.com/zhcw/html/ssq/list.html"; String html = JwtHttpUtil.httpRequest(url, "GET",null); Document doc = Jsoup.parse(html); Document docPageBar= Jsoup.parse(doc.getElementsByClass("pg").toString()); Elements elePageBar = docPageBar.getElementsByTag("strong"); Integer maxPageNo=Integer.parseInt(elePageBar.get(0).text()); return maxPageNo; }以下是执行完成的部分数据截图

拉取到基础数据后,我们可以再写一个job,去计算出每期开奖号码的指标,可以进行奖号分析,预测等。

这里简单实现了部分分析指标的计算,以下是主体代码。

public void run(){ List<LotterySsqKjjlEntity> list= lotterySsqKjjlService.findByQueryString("from LotterySsqKjjlEntity t"); for(int i=0;i<list.size();i++){ LotterySsqKjjlEntity kjjg=list.get(i); logger.info("正在处理:"+kjjg.getSsqKjqh()); kjjg.setSsqMin(kjjg.getSsqR1());//最小号 kjjg.setSsqMax(kjjg.getSsqR6());//最大号 kjjg.setSsqKd(kjjg.getSsqR6()-kjjg.getSsqR1());//号码跨度 kjjg.setSsqJsCnt(ssqKjjgUtils(kjjg, "jsCnt"));//奇数个数 kjjg.setSsqOsCnt(ssqKjjgUtils(kjjg, "osCnt"));//偶数个数 kjjg.setSsqSum(ssqKjjgUtils(kjjg, "sum"));//号码和 lotterySsqKjjlService.updateEntitie(kjjg); } logger.info("结果数据条数"+list.size()); } private Integer ssqKjjgUtils(LotterySsqKjjlEntity kjjg,String opType){ List<Integer> t =new ArrayList<Integer>(); t.add(kjjg.getSsqR1()); t.add(kjjg.getSsqR2()); t.add(kjjg.getSsqR3()); t.add(kjjg.getSsqR4()); t.add(kjjg.getSsqR5()); t.add(kjjg.getSsqR6()); Integer result=0; switch (opType) { case "jsCnt": case "osCnt": int jsgs=0; int osgs=0; for(int i=0;i<t.size();i++){ if(t.get(i)%2==0){ osgs++; }else{ jsgs++; } } if("jsCnt".equals(opType)){ result=jsgs; }else{ result=osgs; } break; case "sum": int sum=0; for(int i=0;i<t.size();i++){ sum+=t.get(i); } result=sum; break; default: break; } return result; }至此,这个简单的爬虫就写完了,可以利用爬过来的这些基础数据,进行一些数据分析,预测。

看完了这篇文章,相信你对“Java如何使用httpRequest+Jsoup爬取红蓝球号码”有了一定的了解,如果想了解更多相关知识,欢迎关注编程网行业资讯频道,感谢各位的阅读!