连发13条推文!刚刚宣布离职的OpenAI「超级对齐团队」负责人Jan Leike在网上自曝离职的真正原因,以及更多内幕。

一来算力不够用,承诺给超级对齐团队的20%缺斤少两,导致团队逆流而行,但也越来越困难。

二来安全不重视,对AGI的安全治理问题,优先级不如推出“闪亮的产品”。

紧接着,更多的八卦被其他人挖出来。

比如OpenAI离职成员都要签一份协议,保证离职后不在外说OpenAI坏话,不签的话视为自动放弃公司股份。

但仍然有拒不签署的“硬骨头”出来放猛料,说核心领导层对安全问题优先级的分歧由来已久。

去年「宫斗」至今,两派的观念冲突到达了临界点,这才看上去颇为体面地崩了。

因此,尽管奥特曼已经派了联合创始人来接管「超级对齐团队」,仍旧不被外界看好。

冲在最一线的推特网友们感谢Jan Leike有勇气说出这个惊人大瓜,并感叹:看来OpenAI真的不太注重这个安全性!

不过回过头来,如今执掌OpenAI的奥特曼这边,暂时还坐得住。

他站出来感谢了Jan Leike对OpenAI超级对齐和安全方面的贡献,表示Jan离开,他其实很难过、很舍不得。

当然了,重点其实是这一句:等着,过两天我会发一篇比这更长的推文。

承诺支持Ilya 20%的算力居然是画大饼

从去年OpenAI宫斗到现在,灵魂人物、前首席科学家Ilya就几乎不再公开露面、公开发声。在他公开宣称离职前,就已经众说纷纭。很多人认为Ilya看到了一些可怕的事情,比如可能毁灭人类的AI系统啥的。

这次Jan Leike算是摊开了说,核心原因就是技术派和市场派对安全方面的优先等级产生了不同看法。分歧很严重,目前后果嘛……大家也都看到了。

据外媒Vox报道,熟悉OpenAI的消息人士透露,更注重安全的员工已经对奥特曼失去了信心,“这是一个信任一点一点崩溃的过程”。但如你所见,在公开平台和场合,没有太多离职员工愿意公开谈论此事。

一部分原因是OpenAI一直以来,都有让员工签署带有非贬低协议的离职协议的传统。如果拒绝签署,就等于放弃了此前拿到的OpenAI的期权,这意味着出来说话的员工可能会损失一笔巨款。

然而,多米诺骨牌还是一张接一张的倒下了——Ilya的辞职加剧了OpenAI近期的离职潮。紧随其后宣布离职的,除了超级对齐团队负责人Jan以外,目前有至少五个安全团队成员离职。其中还有个没签署非贬低协议的硬骨头,比如Daniel Kokotajlo。

Daniel Kokotajlo在2022年加入OpenAI,在治理团队工作,主要工作内容是引导OpenAI安全部署AI。但他也在近期辞职了,并且对外接受了采访:

OpenAI正在训练更强大的AI系统,目标是最终全面超越人类智能。这可能是人类有史以来发生过的最好的事情,但如果我们不小心行事,也可能是最糟糕的事情。

Daniel Kokotajlo阐述,当年他加入OpenAI,满怀对安全治理的报复和希望,期望OpenAI越靠近AGI能越负责任。但团队中许多人慢慢意识到,OpenAI不会这样了。

「逐渐对OpenAI领导层以及他们负责地处理AGI的能力失去了信心」,这就是Daniel Kokotajlo辞职的原因。

对未来AGI安全工作的失望,是Ilya加剧的离职潮中众人离开的一部分原因。

还有一部分原因是超级对齐团队,恐怕没有外界想象的那样能资源充沛地进行研究。即便团队满负荷工作,也只能获得OpenAI承诺的20%的算力。而且团队的一些请求经常被拒绝。

当然是因为算力资源对AI公司来说重要至极,每一点都要合理分配,也因为超级对齐团队的工作是“解决如果公司成功构建AGI,实际上会出现不同类型的安全问题”。

换句话说,超级对齐团队对应的是OpenAI需要面临的未来的安全问题——划重点,是未来的、不知是否会出现的。

截至发稿,奥特曼还没有发出他那篇“比Jan Leike爆料内幕的更长的推文”。但他简单提到,Jan Leike对安全问题的担忧是对的,“我们还有很多事情要做,我们也致力于这样做。”

综上,现在超级对齐团队走了好些人,尤其是Ilya和Jan的离职,让这个风雨之中的团队面临群龙无首的窘况。后续安排,是联合创始人John Schulma来接手,但不再有专门的团队。

新的超级对齐团队将是联系更松散的小组,成员分布在整个公司的各个部门,OpenAI发言人将其描述为“更深入地整合”。

这一点也为外界所质疑,因为John的原本全职工作是确保目前的OpenAI产品的安全问题。

不知道突然多了份责任后,John能不能忙得过来,好好领导关注现在和关注未来安全问题的两个团队?

Ilya vs Altman之争

如果把时间阵线拉长, 其实今天的分崩离析是OpenAI“宫斗”,其实就是Ilya-Altman之争的续集。时间回溯到去年11月,当时Ilya还在,他同OpenAI董事会合作试图解雇掉奥特曼。当时给出的理由是,他在沟通中不够真诚。换言之,我们不信任他。

但最终结果显而易见,奥特曼带着他的“盟友”威胁加入微软,结果董事会屈服,罢免行动失败。Ilya离开董事会。而奥特曼这边,选择了对他更为有利的成员加入董事会。

在这之后,Ilya就再也社交平台上消失了,直至前几天官宣离职。而且据说,已经大约6个月没有出现在OpenAI办公室了。当时他还留下一条耐人寻味的推文,但很快就删除了。

在过去的一个月里,我吸取了许多教训。其中一个教训是,「在士气提高之前,殴打会一直持续下去」这句话比它应有的含义更经常地适用。

但据内部人士透露,Ilya一直远程共同领导着超级对齐团队。

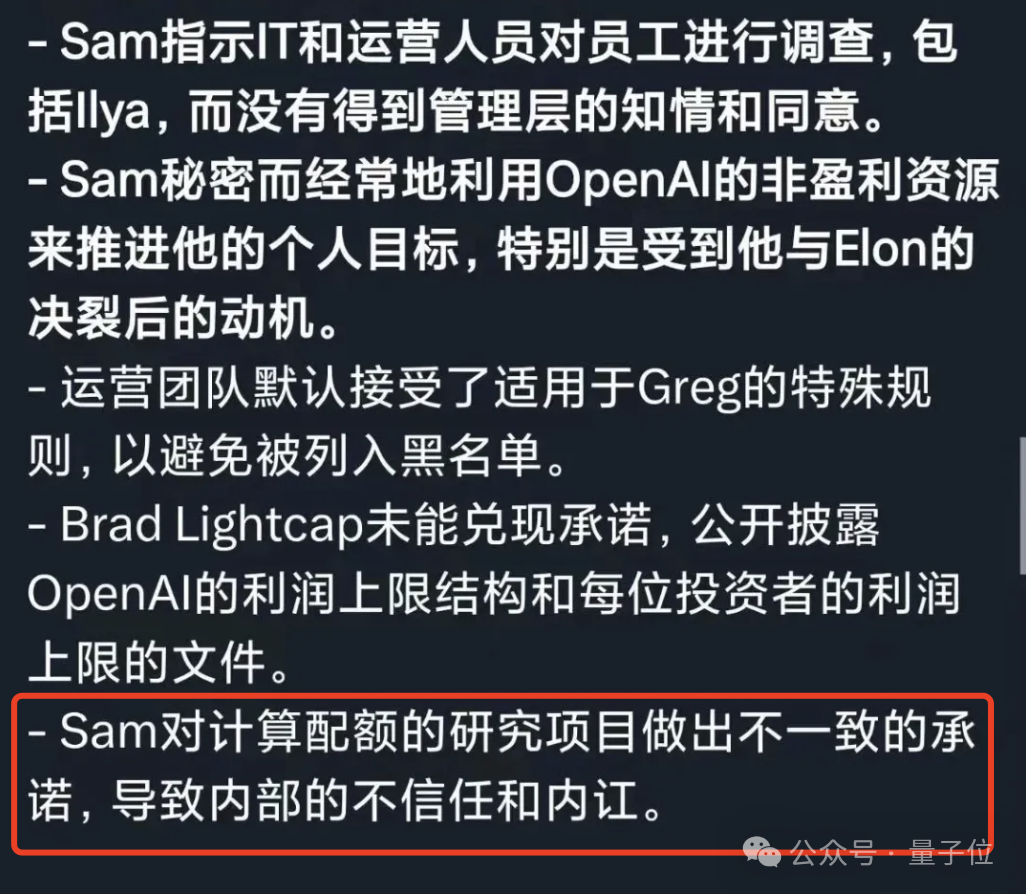

而在奥特曼这边,员工们对他最大的指控就是言行不一,比如他声称自己想优先考虑安全,但他的行为却很矛盾。

除了原本承诺的计算资源没有给到外。还有像前阵子找沙特等筹集资金来造芯。那些注重安全的员工懵了。如果他真的关心以尽可能安全的方式构建和部署人工智能,那么就不会这么疯狂地积累芯片,来加速技术的发展?

更早之前,OpenAI还从一家奥特曼投资的一家初创公司订购芯片,金额高达5100万美元。

而当时宫斗那几天OpenAI前员工的举报信中,对于奥特曼的描述似乎也再一次印证。

也正因这样从始至终“言行不一”的操作,让员工们逐渐对OpenAI以及奥特曼失去信心。

Ilya是这样,Jan Laike是这样,「超级对齐团队」也是这样。

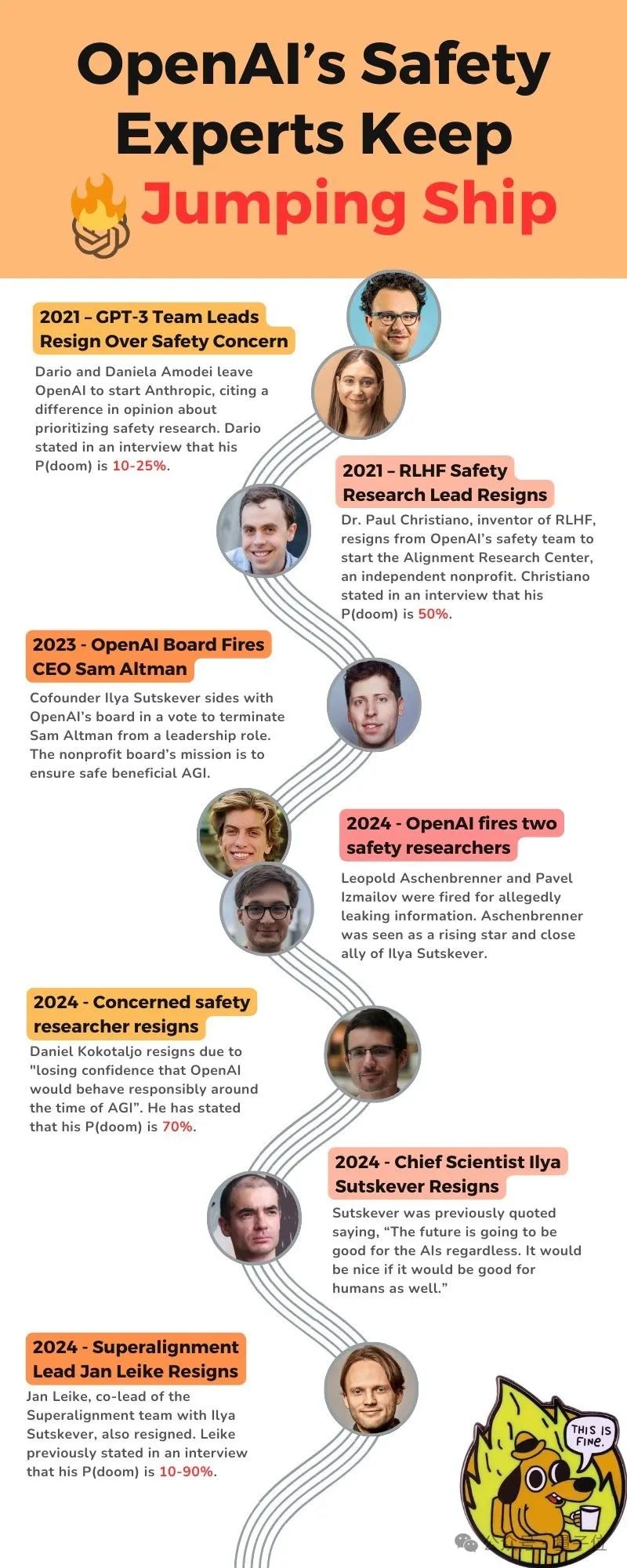

有贴心的网友整理出这几年年间,发生的相关事情的重要节点——先来个贴心提示,下文提到的P(doom),指“AI引发世界末日场景的可能性”。

2021年,GPT-3团队负责人因“安全”问题离开OpenAI,创立Anthropic;其中一位认为P(doom)为10-25%;

2021年,RLHF安全研究负责人离职,P(doom)为50%;

2023年,OpenAI董事会解雇奥特曼;

2024年,OpenAI解雇两位安全研究员;

2024年,一位特别关注安全的OpenAI研究员离职,他认为P(doom)已经在70%。

2024年,Ilya、JAN Laike离职。

选择技术派还是市场派路线?

大模型发展至今,「如何实现AGI?」其实可归结为两条路线。技术派希望技术成熟可控再应用,市场派则认为边开放边应用“渐进式”走到终点。

这也是Ilya vs Altman理念之争的根本分歧,即OpenAI的使命:到底是专注于AGI和「超级对齐」,还是专注于扩展ChatGPT的各项服务?