怎么在vmware中搭建一个Hadoop集群环境?很多新手对此不是很清楚,为了帮助大家解决这个难题,下面小编将为大家详细讲解,有这方面需求的人可以来学习下,希望你能有所收获。

先在虚拟机中关闭系统

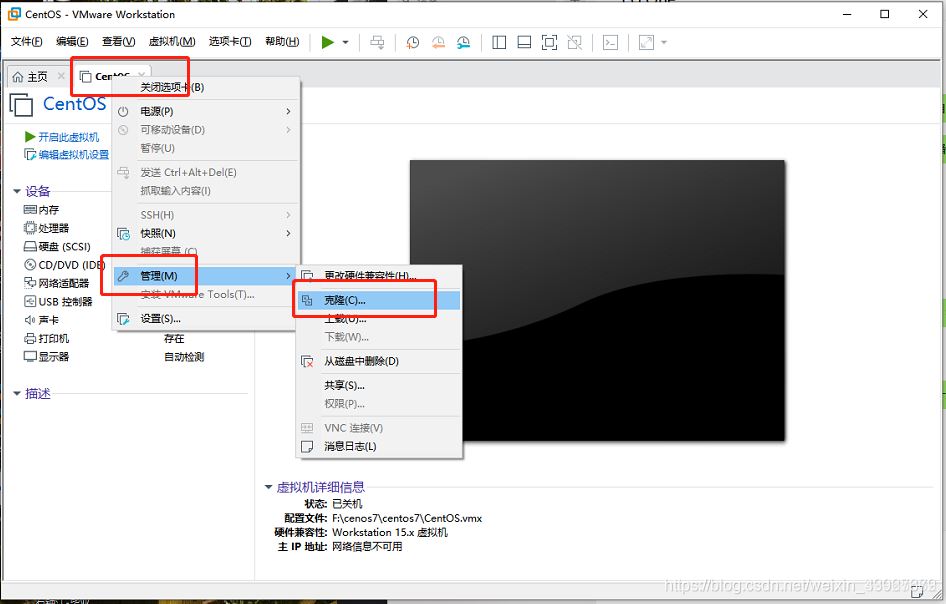

右键虚拟机,点击管理,选择克隆

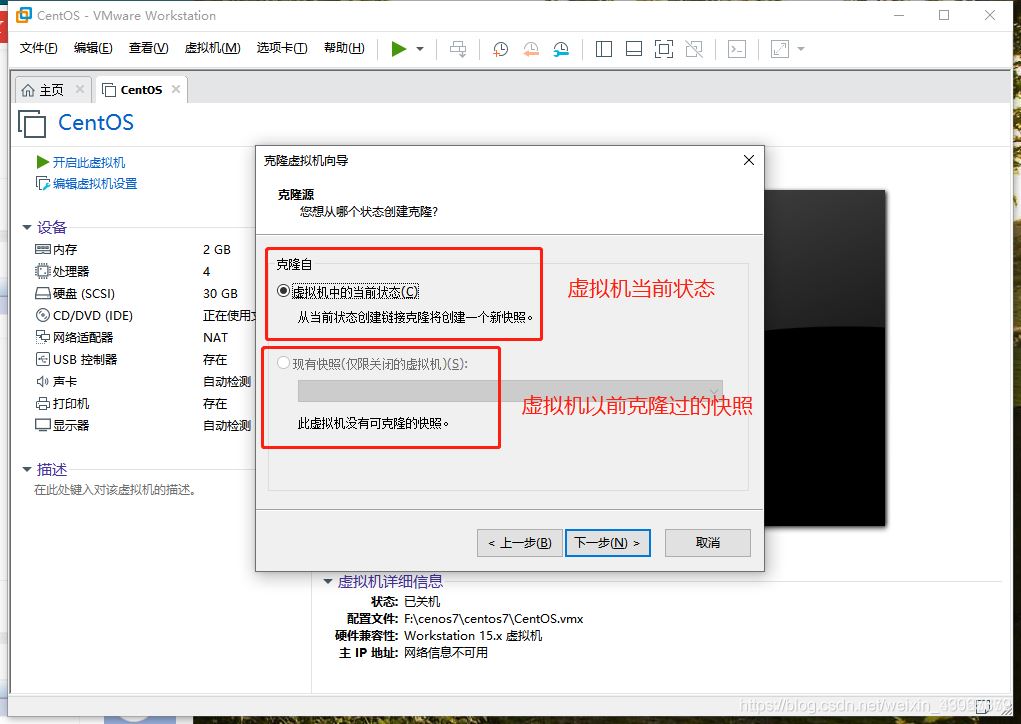

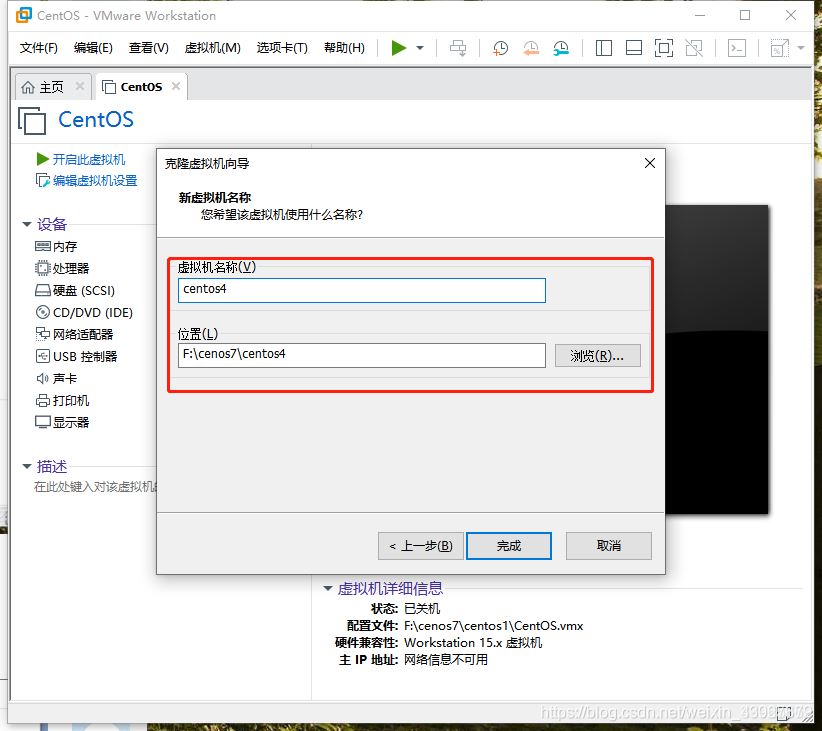

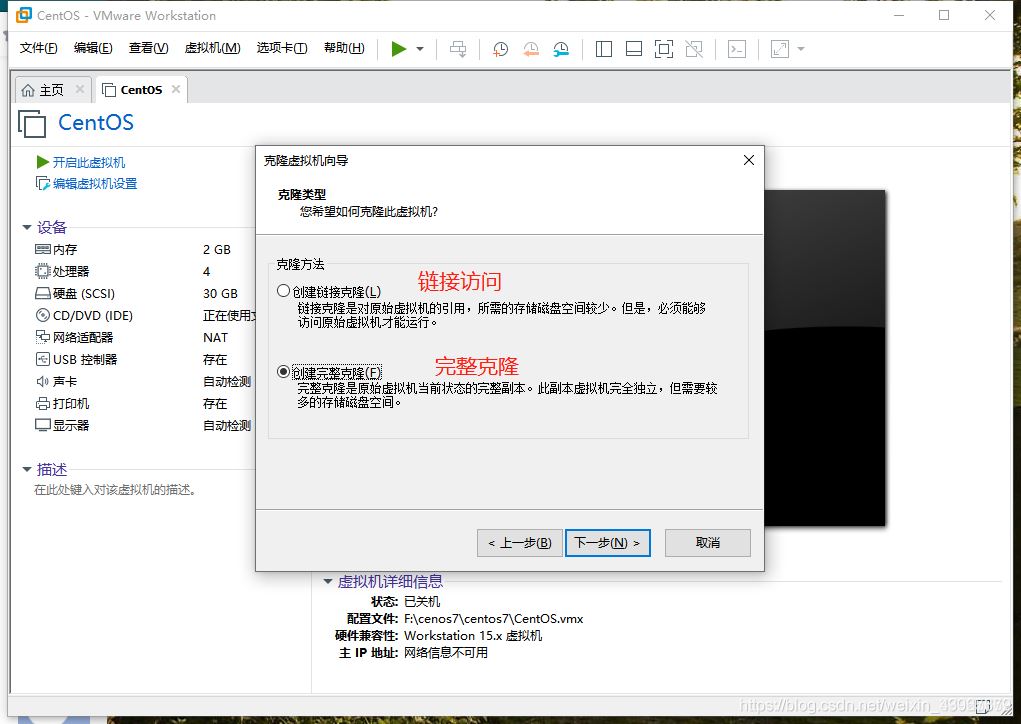

点击下一步,选择完整克隆,选择路径即可

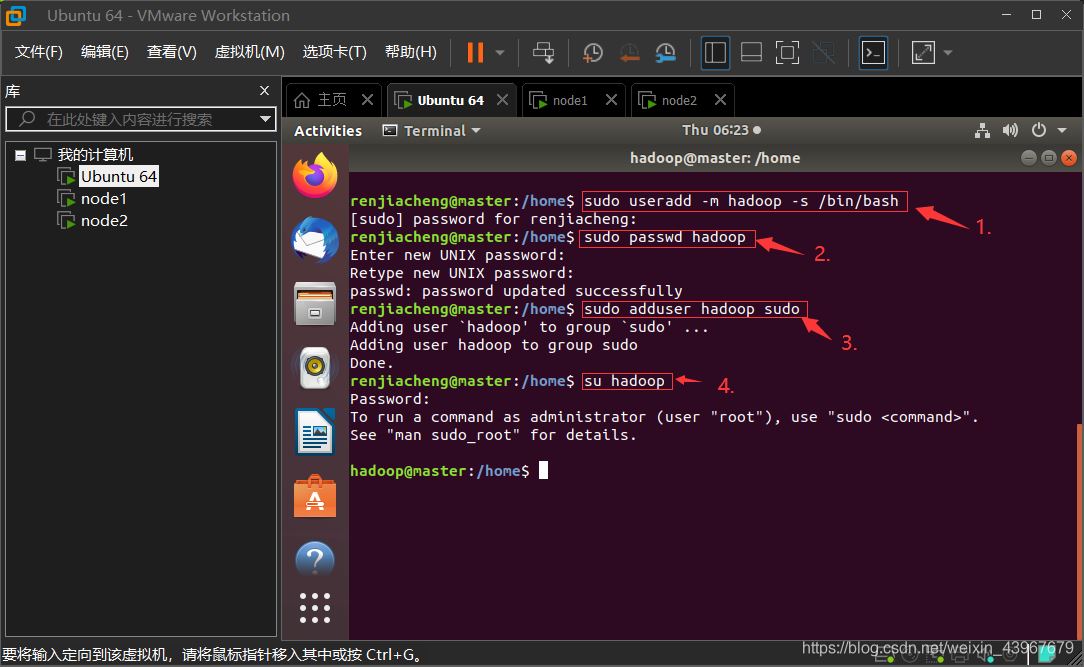

1.创建Hadoop用户(在master,node1,node2执行)

顺序执行以下命令即可

创建hadoop用户

sudo useradd -m hadoop -s /bin/bash设置用户密码(输入两次)

sudo passwd hadoop添加权限

sudo adduser hadoop sudo切换到hadoop用户(这里要输入刚刚设置的hadoop密码)

su hadoop运行截图展示(以master虚拟机为例)

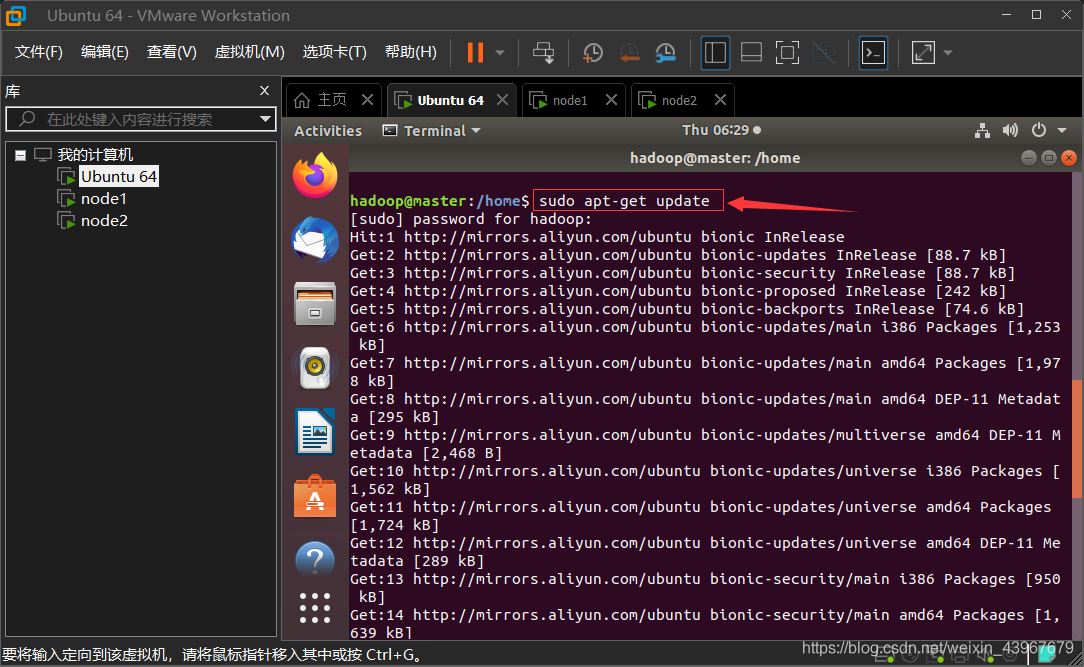

2.更新apt下载源(在master,node1,node2执行)

sudo apt-get update截图展示(以master为例)

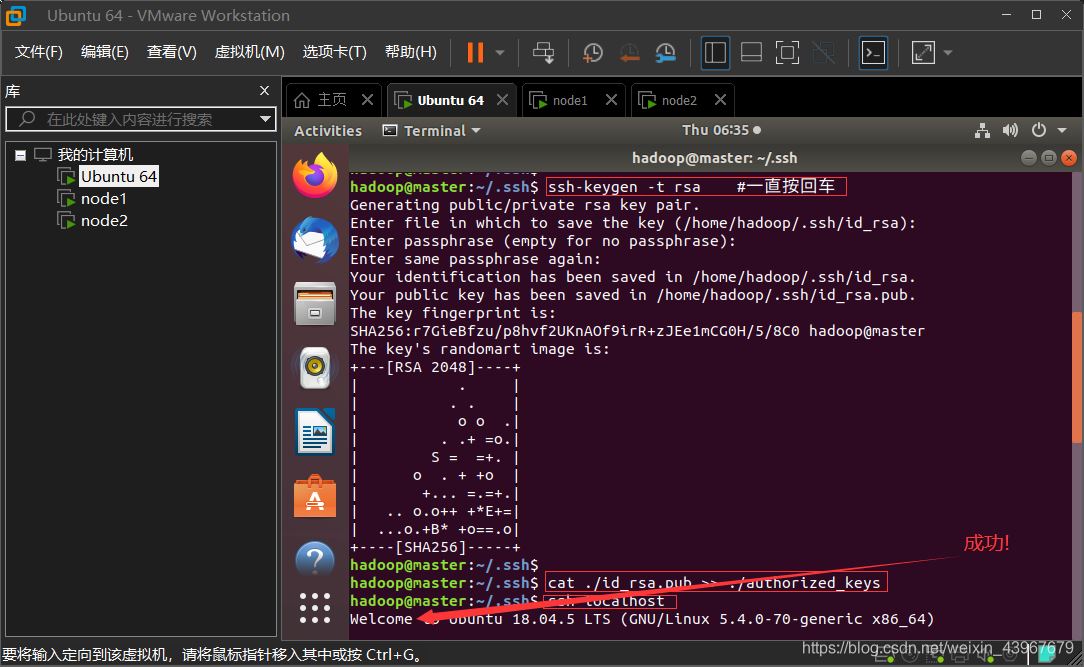

3. 安装SSH、配置SSH免密登录 (在master,node1,node2执行)

安装SSH

sudo apt-get install openssh-server配置SSH免密登录

ssh localhostexit cd ~/.ssh/ ssh-keygen -t rsa #一直按回车cat ./id_rsa.pub >> ./authorized_keys验证免密

ssh localhostexit cd ~/.ssh/ ssh-keygen -t rsa #一直按回车cat ./id_rsa.pub >> ./authorized_keys截图展示(以master为例)

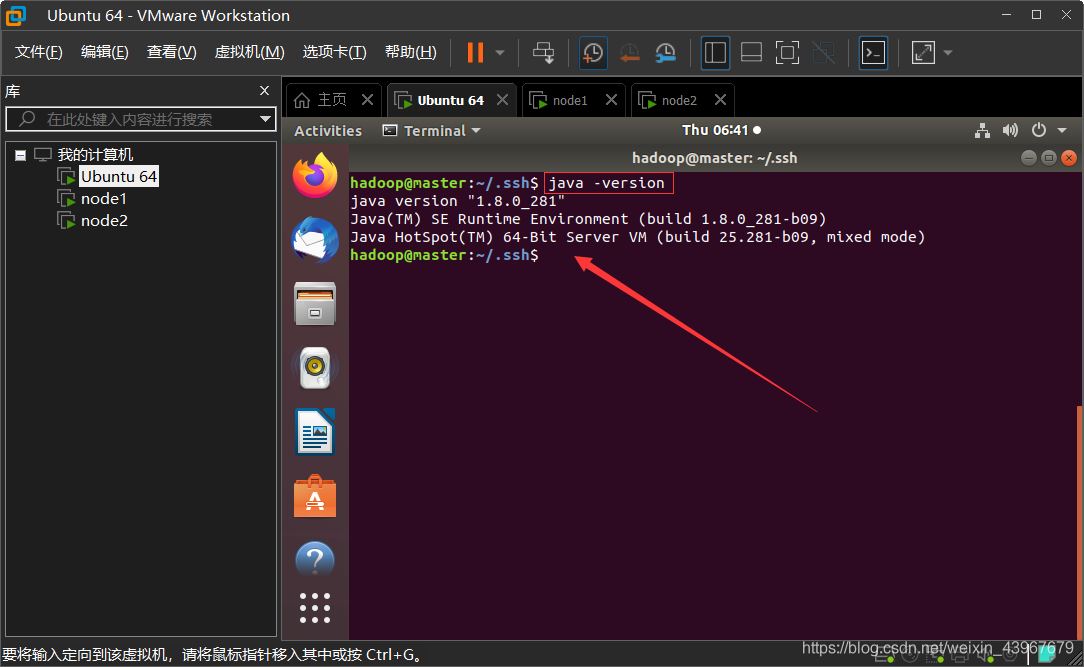

4.安装Java环境 (在master,node1,node2执行)

下载 JDK 环境包

sudo apt-get install default-jre default-jdk配置环境变量文件

vim ~/.bashrc在文件首行加入

export JAVA_HOME=/usr/lib/jvm/default-java4,。让环境变量生效

source ~/.bashrc验证

java -version截图展示(以master为例)

修改主机名(在master,node1,node2执行)

将文件中原有的主机名删除,master中写入master,node1中写入node1,node2…(同理)

sudo vim /etc/hostname重启三个服务器

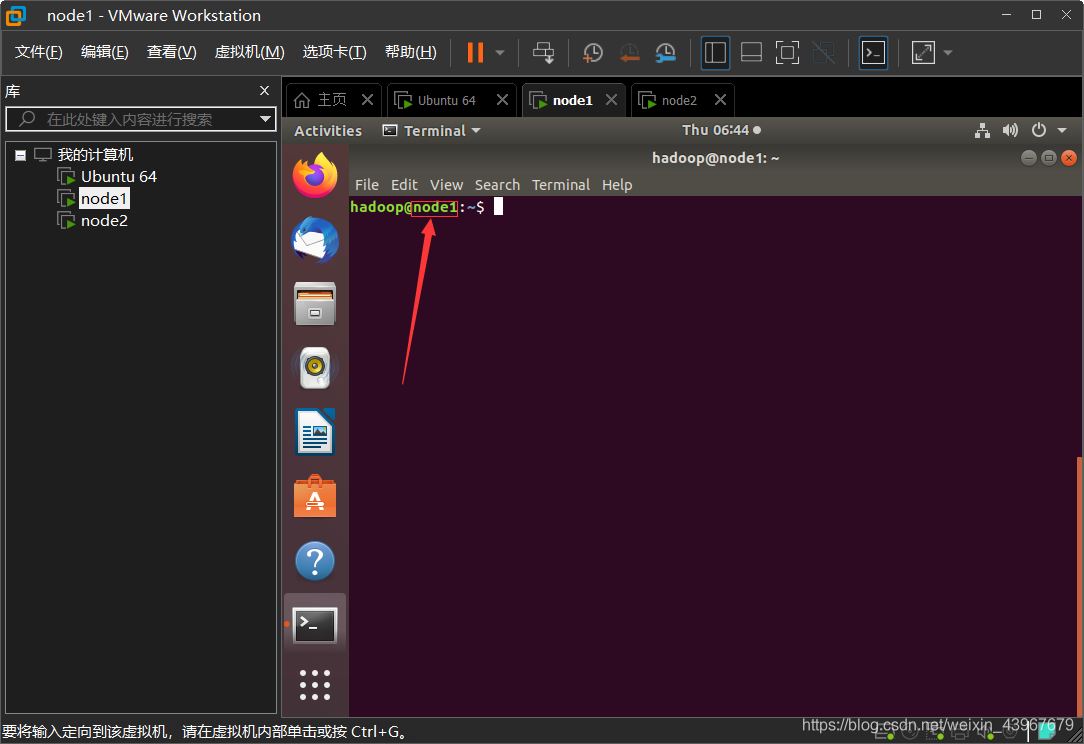

reboot重启成功后,再次连接会话,发现主机名改变了

截图展示(以node1为例)

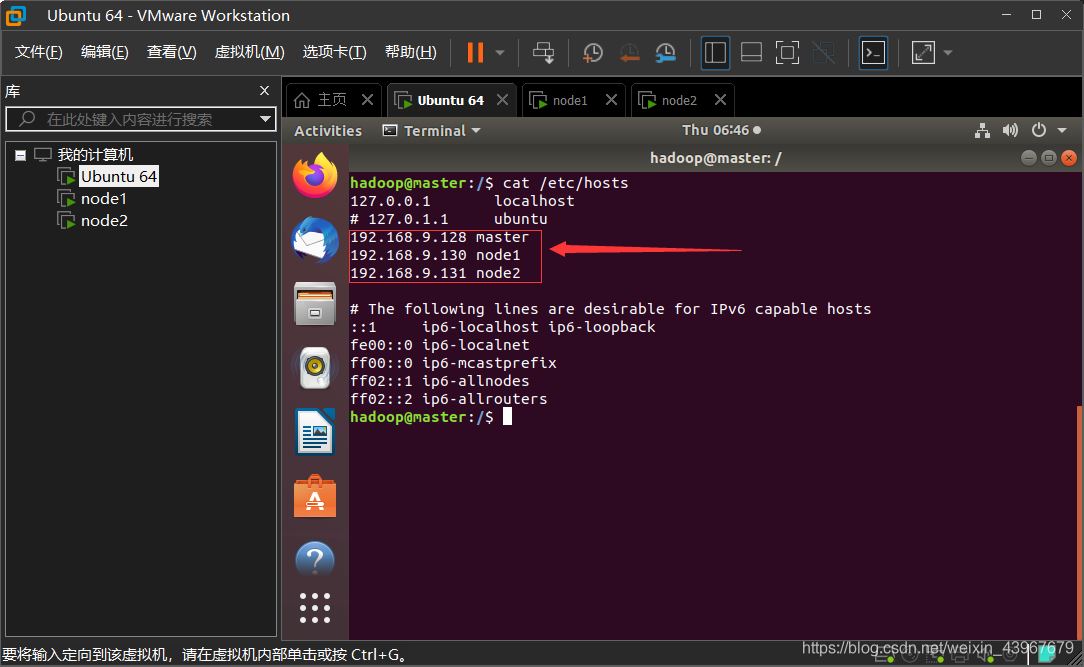

修改IP映射(在master,node1,node2执行)

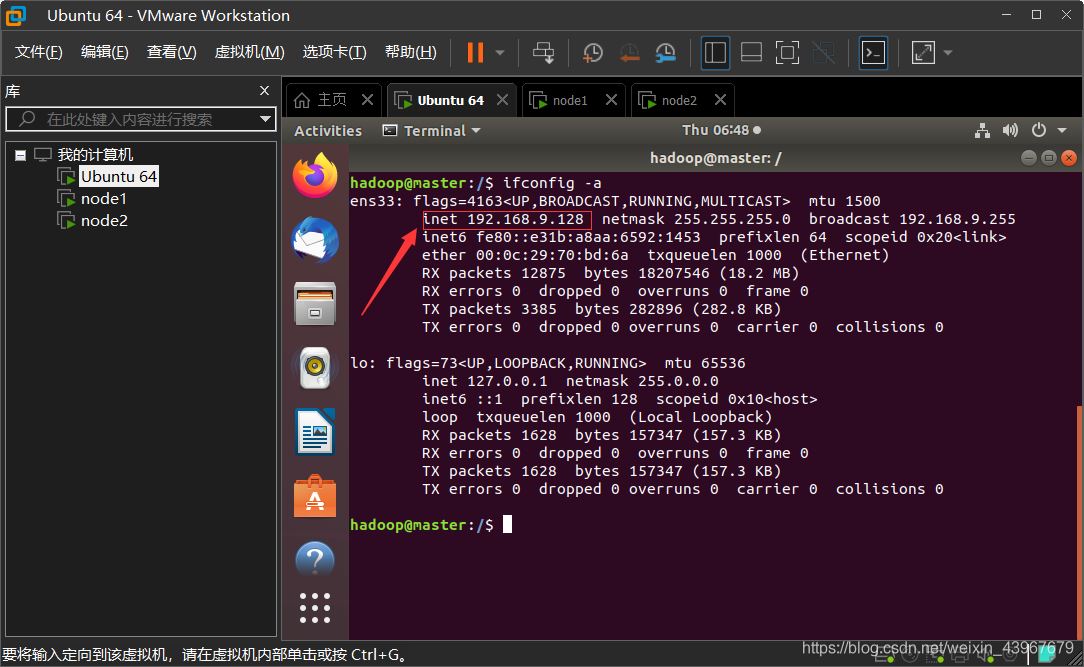

查看各个虚拟机的ip地址

ifconfig -a如果有报错,则下载 net-tools ,然后再运行即可看到

sudo apt install net-tools如下图,红色方框内的就是 本台虚拟机的 ip 地址

3台虚拟机中都需要在 hosts 文件中加入对方的ip地址

sudo vim /etc/hosts以master为例截图展示

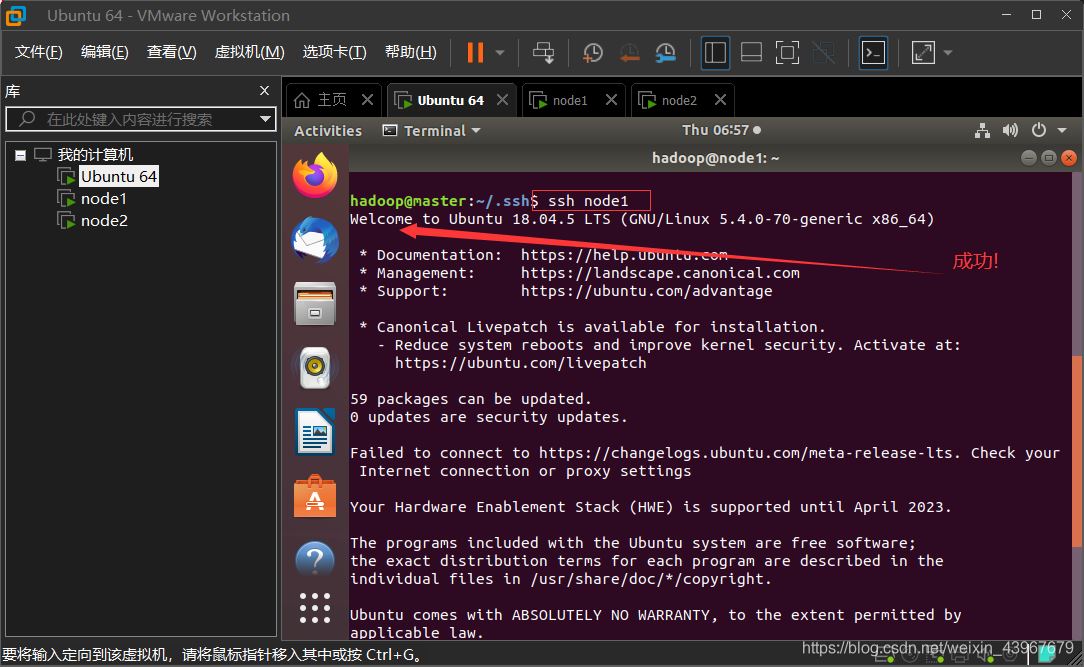

SSH免密登录其他节点(在master上执行)

在Master上执行

cd ~/.ssh rm ./id_rsa* # 删除之前生成的公匙(如果有)ssh-keygen -t rsa # 一直按回车就可以cat ./id_rsa.pub >> ./authorized_keysscp ~/.ssh/id_rsa.pub hadoop@node1:/home/hadoop/scp ~/.ssh/id_rsa.pub hadoop@node2:/home/hadoop/

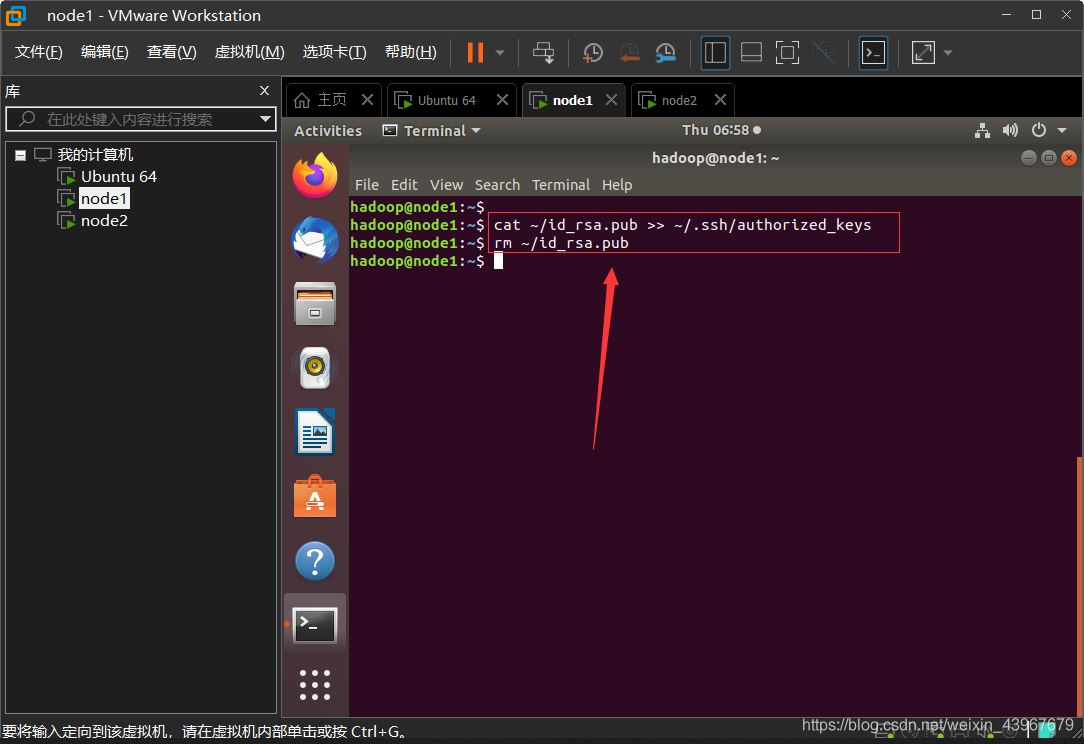

在node1,node2都执行

cat ~/id_rsa.pub >> ~/.ssh/authorized_keysrm ~/id_rsa.pub # 用完就删掉

验证免密登录

ssh node1exitssh node2exit以master为例截图展示

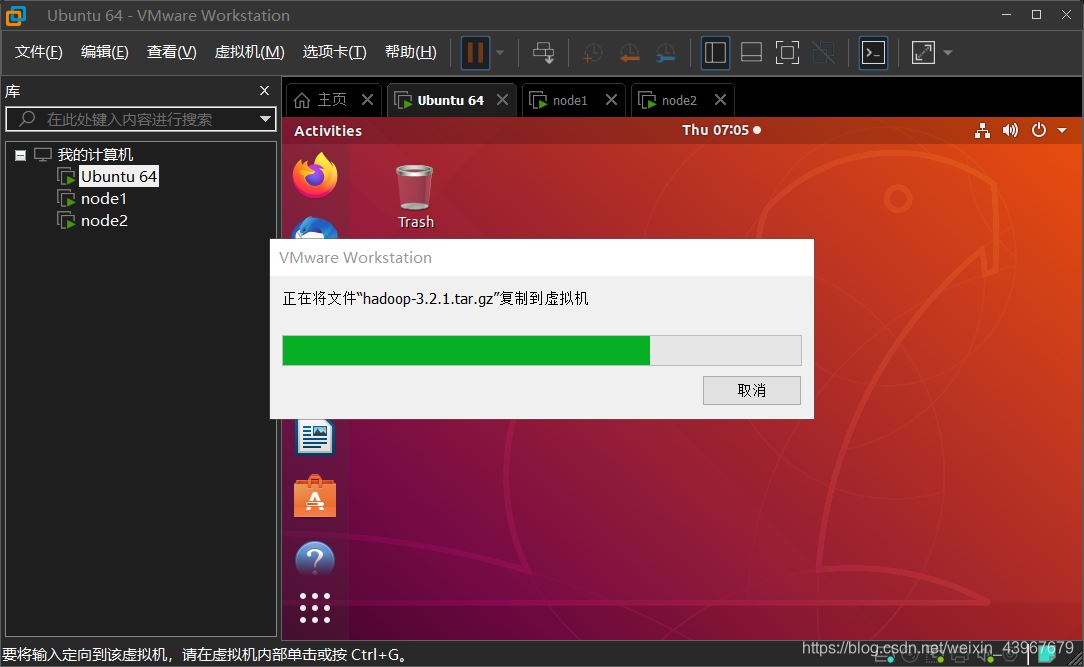

安装hadoop3.2.1(在master中执行)

有些镜像的下载网址失效了,这里贴出官网的下载地址。

下载网址:hadoop3.2.1下载网址

下载好,之后通过VMware-Tools上传到master的/home/hadoop中

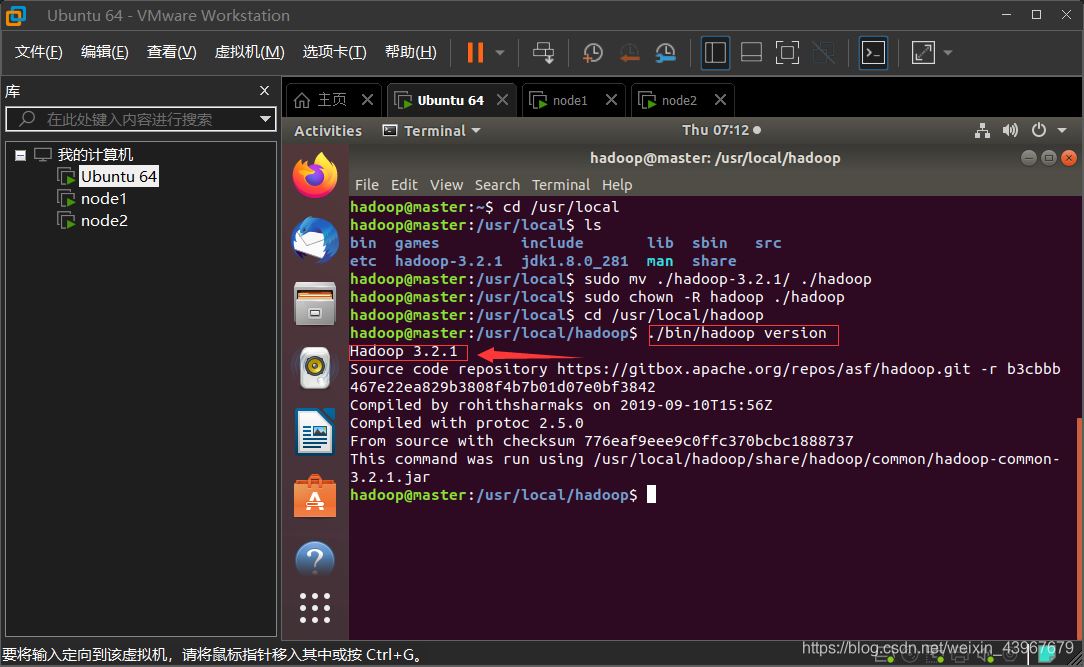

解压

cd /home/hadoopsudo tar -zxf hadoop-3.2.1.tar.gz -C /usr/local #解压cd /usr/local/sudo mv ./hadoop-3.2.1/ ./hadoop # 将文件夹名改为hadoopsudo chown -R hadoop ./hadoop # 修改文件权限验证

cd /usr/local/hadoop./bin/hadoop version

配置hadoop环境(这一步需要很仔细)

配置环境变量

vim ~/.bashrc在首行中写入

export HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin使得配置生效

source ~/.bashrc创建文件目录(为后面的xml做准备)

cd /usr/local/hadoopmkdir dfscd dfsmkdir name data tmpcd /usr/local/hadoopmkdir tmp配置hadoop的java环境变量

vim $HADOOP_HOME/etc/hadoop/hadoop-env.shvim $HADOOP_HOME/etc/hadoop/yarn-env.sh两个的首行都写入

export JAVA_HOME=/usr/lib/jvm/default-java(master中)配置nodes

cd /usr/local/hadoop/etc/hadoop删除掉原有的localhost,因为我们有2个node,就把这2个的名字写入

vim workersnode1node2配置 core-site.xml

vim core-site.xml因为我们只有一个namenode,所以用fs.default.name,不采用fs.defalutFs

其次确保/usr/local/hadoop/tmp这个目录存在

<configuration> <property> <name>fs.default.name</name> <value>hdfs://Master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/hadoop/tmp</value> </property></configuration>配置 hdfs-site.xml

vim hdfs-site.xmldfs.namenode.secondary.http-address确保端口不要和core-site.xml中端口一致导致占用

确保/usr/local/hadoop/dfs/name :/usr/local/hadoop/dfs/data 存在

因为我们只有2个node,所以dfs.replication设置为2

<configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>Master:9001</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/usr/local/hadoop/dfs/data</value> </property> <property> <name>dfs.replication</name> <value>2</value> </property></configuration>配置mapred-site.xml

vim mapred-site.xml<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property></configuration>配置 yarn-site.xml

vim yarn-site.xml<configuration> <property> <name>yarn.resourcemanager.hostname</name> <value>Master</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property></configuration>将hadoop压缩

cd /usr/localtar -zcf ~/hadoop.master.tar.gz ./hadoop #压缩cd ~复制到node1中

scp ./hadoop.master.tar.gz node1:/home/hadoop复制到node2中

scp ./hadoop.master.tar.gz node2:/home/hadoop在node1、node2上执行

解压

sudo rm -r /usr/local/hadoop # 删掉旧的(如果存在)sudo tar -zxf ~/hadoop.master.tar.gz -C /usr/local #解压sudo chown -R hadoop /usr/local/hadoop #修改权限首次启动需要先在 Master 节点执行 NameNode 的格式化,之后不需要

hdfs namenode -format(注意:如果需要重新格式化 NameNode ,才需要先将原来 NameNode 和 DataNode 下的文件全部删除!!!!!!!!!)

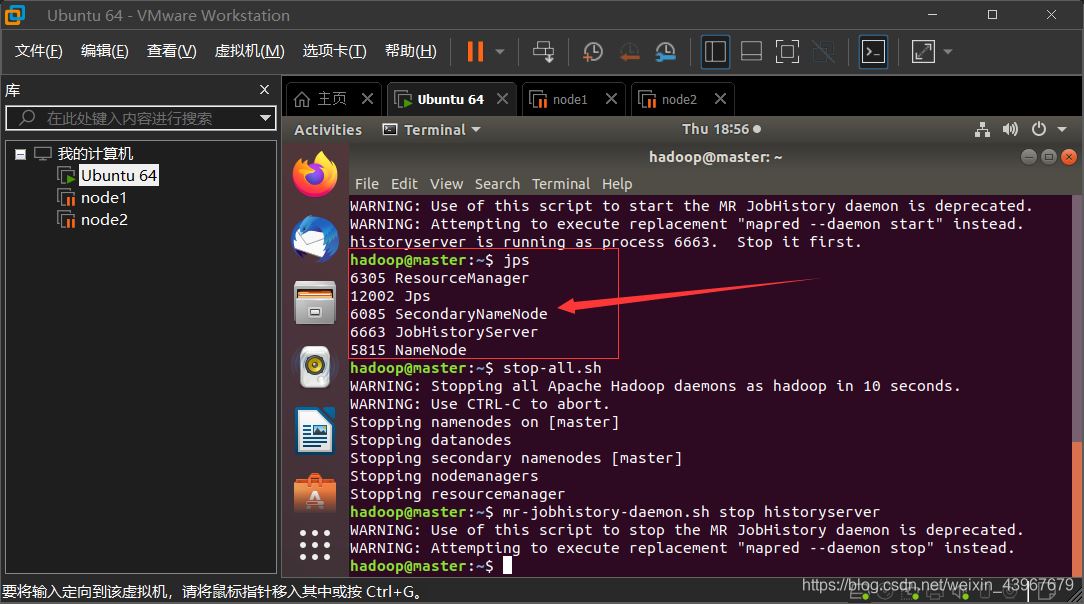

#看上面的文字,不要直接复制了rm -rf $HADOOP_HOME/dfs/data/*rm -rf $HADOOP_HOME/dfs/name/*启动 (在master上执行)

start-all.shmr-jobhistory-daemon.sh start historyservermaster中,出现Warning不影响

jps运行截图展示

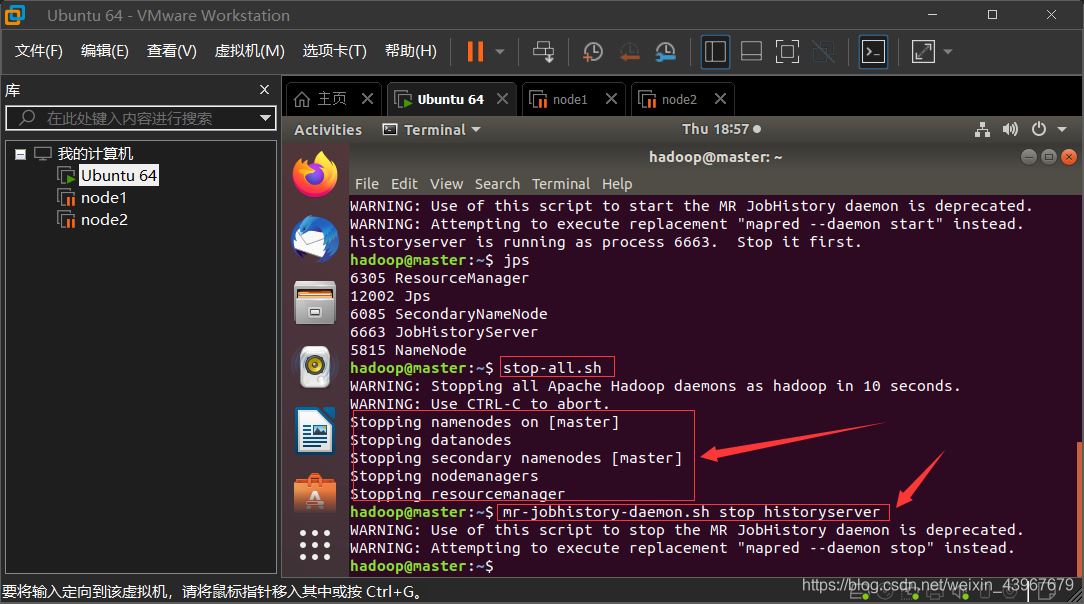

关闭hadoop集群(在master上执行)

stop-all.shmr-jobhistory-daemon.sh stop historyserver运行截图展示

看完上述内容是否对您有帮助呢?如果还想对相关知识有进一步的了解或阅读更多相关文章,请关注编程网行业资讯频道,感谢您对编程网的支持。