Transformer

Pytorch怎么实现Transformer

本篇内容主要讲解“Pytorch怎么实现Transformer”,感兴趣的朋友不妨来看看。本文介绍的方法操作简单快捷,实用性强。下面就让小编来带大家学习“Pytorch怎么实现Transformer”吧!一、构造数据1.1 句子长度# 关于

云服务器训练transformer模型

云服务器训练transformer模型可以使用分布式训练或者集群训练。分布式训练是指使用多个独立的节点进行训练,每个节点都有自己的模型进行训练。训练数据可以来自多个机器、机器之间的通信以及网络连接状态等信息。分布式训练可以提高训练速度和模型的准确性。集群训练是指通过将多个节点连接成一个集群来提高训练速度和模型的准确性。训练数据可以来自多个机器、机器之间的通信以及网络连接状态等信息。集群训练可

Vision Transformer图像分类模型是什么

本篇内容介绍了“Vision Transformer图像分类模型是什么”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成!Vision Trans

PyTorch中的Transformer模型是如何实现的

在PyTorch中,Transformer模型主要由以下几个部分组成:Encoder:包括多个Encoder层,每个Encoder层由多头自注意力机制和前馈神经网络组成。Encoder的作用是将输入的序列进行特征提取和编码。Decoder:

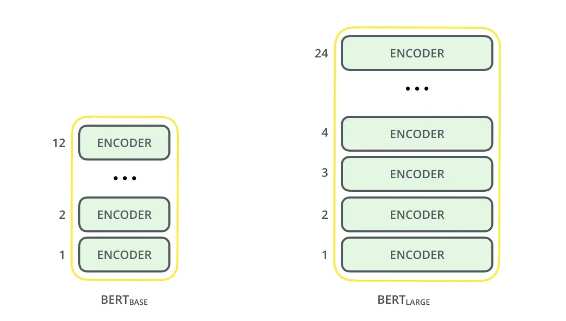

Transformer之Bert预训练语言解析的方法是什么

今天小编给大家分享一下Transformer之Bert预训练语言解析的方法是什么的相关知识点,内容详细,逻辑清晰,相信大部分人都还太了解这方面的知识,所以分享这篇文章给大家参考一下,希望大家阅读完这篇文章后有所收获,下面我们一起来了解一下吧

详解基于Transformer实现电影评论星级分类任务

这篇文章主要为大家介绍了详解基于Transformer实现电影评论星级分类任务过程解析,有需要的朋友可以借鉴参考下,希望能够有所帮助,祝大家多多进步,早日升职加薪

Swin Transformer模块集成到YOLOv5目标检测算法中实现

这篇文章主要为大家介绍了Swin Transformer模块集成到YOLOv5目标检测算法中实现示例详解,有需要的朋友可以借鉴参考下,希望能够有所帮助,祝大家多多进步,早日升职加薪

百闻不如一码!手把手教你用Python搭一个Transformer

大数据文摘出品编译:林安安、钱天培与基于RNN的方法相比,Transformer 不需要循环,主要是由Attention 机制组成,因而可以充分利用python的高效线性代数函数库,大量节省训练时间。可是,文摘菌却经常听到同学抱怨,Tran

详解Swin Transformer核心实现,经典模型也能快速调优

Swin Transformer是一种基于Transformer结构的图像分类模型,其核心实现主要有以下几个方面:1. 分块式图片处理:Swin Transformer将输入图片分为多个非重叠的小块,每个小块称为一个局部窗格。然后通过局部窗