分词检索

ElasticSearch怎么实现分词全文检索

Elasticsearch是一个基于Lucene的搜索引擎,它提供了强大的全文搜索和分析能力。要实现分词全文检索,你可以按照以下步骤进行操作:安装Elasticsearch:首先需要安装Elasticsearch并启动服务。创建索引:在El

Sphinx PHP 实现全文搜索的中文分词与检索优化

引言:随着互联网的发展和信息爆炸的时代,全文搜索引擎成为了人们进行信息检索的重要工具。传统的全文搜索引擎主要针对英文等西方语言进行优化,而对于中文这种特殊的语言来说,传统的全文搜索引擎存在一些问题。本文将介绍如何利用Sphinx PHP实现

基于python + django + whoosh + jieba 分词器实现站内检索功能

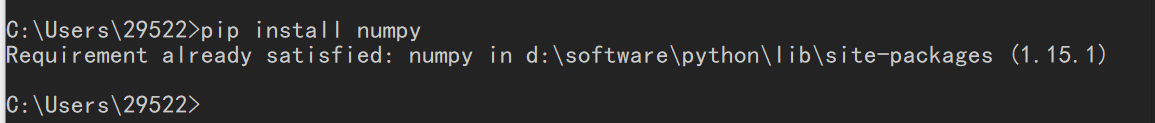

基于 python django 源码 前期准备 安装库:pip install django-haystack pip install whoosh pip install jieba如果pip 安装超时,可配置pip国内源下载,如下:p

02_输入检索词自动爬取百度搜索页标题信

背景:在百度每次输入关键词检索后,会出现很多的检索页,不利于有效阅读,为更方便收集检索信息,编写了一个可以收集每个检索页与检索词相关的十条检索信息(百度在每个检索页放置十条检索标题信息)。可以根据需要选择爬取多少检索页,通过修改main()

Forespider使用教程---如何采集关键词检索结果

如何采集关键词检索结果,今天前嗅大数据就以古诗文网为例为大家演示,话不多说一起看看吧。 一. 网站内容 1. 网站截图说明 本教程通过“古诗文网”官网来采集所需“关键词”的正文数据,本教程以关键词“鹅鹅鹅”为例,故链接入口为:https://so.gushiw

postgres 中文全文分词搜索实例

Dockerfile# If you don‘t want to build it youself, you can try `docker pull killercai/postgres`.FROM healthcheck/postgres:latest#

MySQL也可以实现分词搜索(FULLTEXT)

FULLTEXT 以前使用查找时都是以 %关键字% 进行模糊查询结果的,这种查询方式有一些缺点,比如不能查询多个列必须手动添加条件以实现,效率不高等 现在有一种新的查找方式可以解决以上问题,就是使用全文索引进行查找 注意:并非所有存储引擎都

搜索一文入门ElasticSearch(节点分片CRUD倒排索引分词)

这篇文章主要为大家介绍了搜索一文入门ElasticSearch(节点分片CRUD倒排索引分词)的基础详解,有需要的朋友可以借鉴参考下,希望能够有所帮助,祝大家多多进步,早日升职加薪

Xunsearch搜索的文本分析与分词器开发(如何为Xunsearch开发文本分析和分词器?)

Xunsearch搜索引擎中,文本分析与分词器负责将文本拆解成词语供索引和检索。开发分词器时需遵循以下步骤:了解文本分析和分词、选择分词算法、定义分词规则、构建分词器、评估分词器、集成到Xunsearch、优化分词器。常见用例包括全文检索、分面搜索、自然语言处理。最重要的是选择合适的算法、规则并定期优化分词器。

ElasticSearch节点、分片、CRUD、倒排索引和分词源码分析

这篇文章主要介绍了ElasticSearch节点、分片、CRUD、倒排索引和分词源码分析的相关知识,内容详细易懂,操作简单快捷,具有一定借鉴价值,相信大家阅读完这篇ElasticSearch节点、分片、CRUD、倒排索引和分词源码分析文章都

Python Pytorch图像检索实例分析

这篇文章主要介绍“Python Pytorch图像检索实例分析”,在日常操作中,相信很多人在Python Pytorch图像检索实例分析问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”Python Pytorc

Xunsearch搜索的中文分词算法优化(如何优化Xunsearch的中文分词算法?)

Xunsearch中文分词算法优化策略包括:扩展分词词典、调整分词策略、使用同义词库、应用形态学分词、集成外部分词器、自主学习和性能优化。通过优化分词算法,可以提高Xunsearch搜索的效率和准确度,从而提升用户搜索体验。

PHPCMS取消搜索时的分词功能的方法

phpcms的搜索功能相比其他CMS算是比较差的了,搜索精度非常低。虽说他有个搜索关键字分词功能,但有的时候不分词的准确度却会高于分词。如何去掉PHPCMS关闭http://www.cppcns.com搜索关键字分词功能? 用记事本打开 \

利用词云图分析热词

1.安装第三方库(matplotlib,jieba,wordcloud,numpy) 1.1安装方法:pip命令在线安装(python3.x默认安装了pip,pip下载地址:https://pypi.python.org/pypi/pip

Xunsearch搜索的自定义分词器开发与应用(如何为Xunsearch开发自定义的分词器?)

Xunsearch中自定义分词器该文章介绍了如何开发和使用Xunsearch中的自定义分词器。自定义分词器允许用户为特定的语言、方言或专业领域创建定制化文本分词处理,以增强搜索结果的准确性和相关性。文章具体讲述了分词器开发步骤、分词器应用和高级特性,并给出了应用示例,如中文分词、关键词提取、地理搜索和专业领域搜索。