RDD

4.RDD操作

目录一、 RDD创建从本地文件系统中加载数据创建RDD从HDFS加载数据创建RDD通过并行集合(列表)创建RDD二、 RDD操作转换操作filter(func)map(func)flatMap(func)reduceByKey()groupByKey()sor

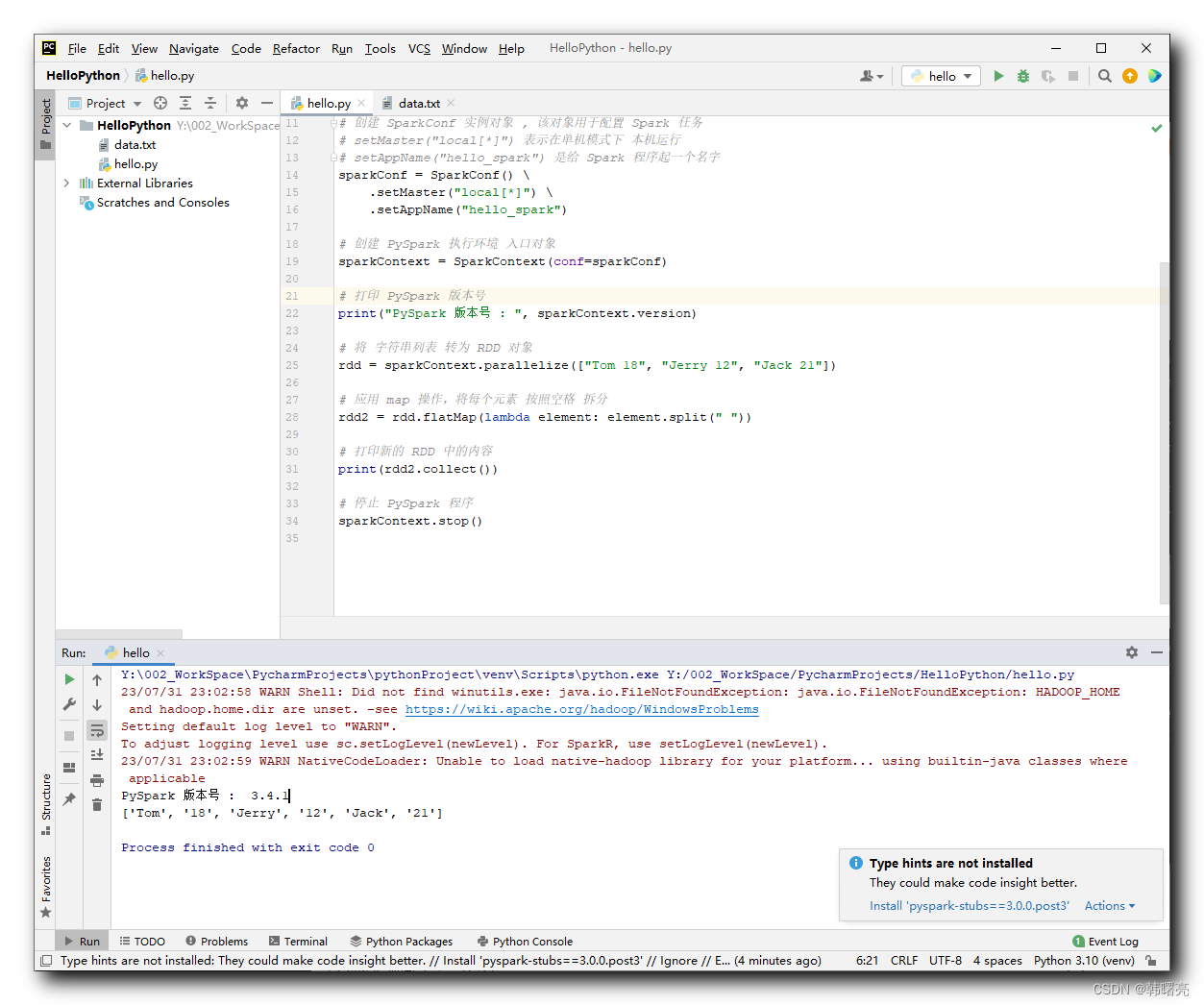

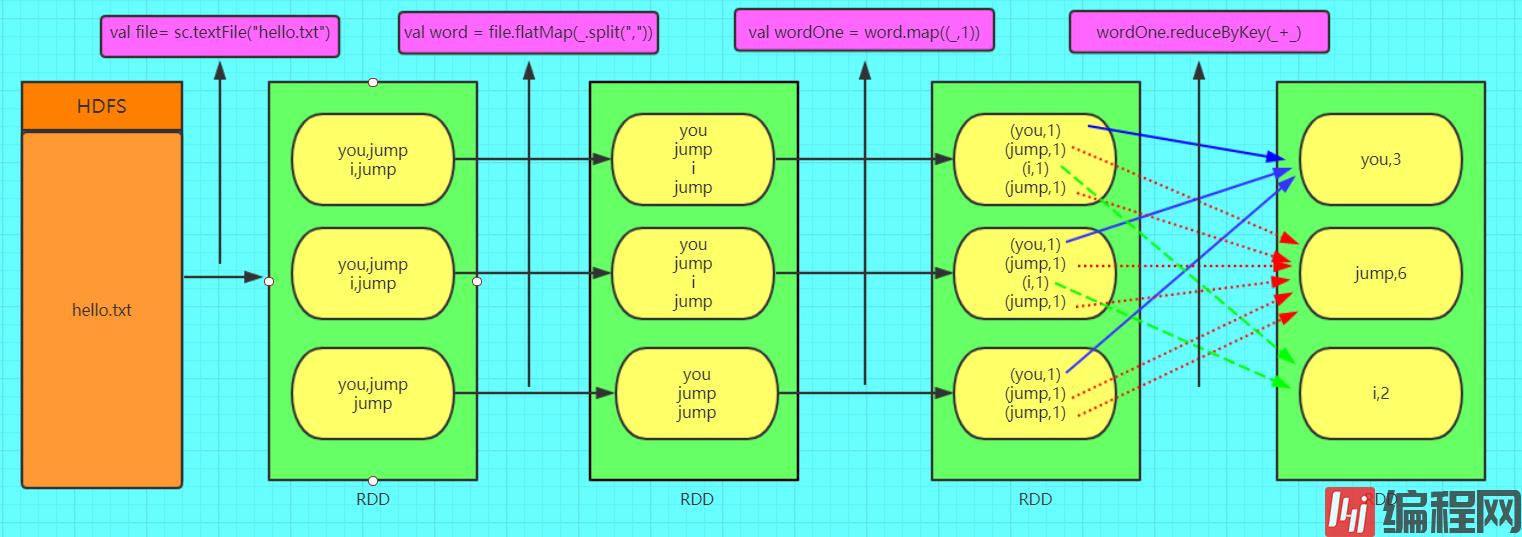

【Python】PySpark 数据计算 ③ ( RDD#reduceByKey 函数概念 | RDD#reduceByKey 方法工作流程 | RDD#reduceByKey 语法 | 代码示例 )

Spark基础和RDD

spark1. Spark的四大特性速度快spark比mapreduce快的两个原因基于内存1. mapreduce任务后期在计算的是时候,每一个job的输出结果都会落地到磁盘,后续有其他的job要依赖于前面job的输出结果,这个时候就需要进行大量的磁盘io操

spark计算模型RDD

RDD介绍1.RDD概念以及特性RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。RDD具有数据流模型的特点:自动容错、位置感知性调度

Spark RDD的内容有哪些

这篇文章将为大家详细讲解有关Spark RDD的内容有哪些,文章内容质量较高,因此小编分享给大家做个参考,希望大家阅读完这篇文章后对相关知识有一定的了解。一.添加jar包运行1.官网位置点击步骤:Spark Programming Guid

RDD的类型有哪些

这篇文章主要讲解了“RDD的类型有哪些”,文中的讲解内容简单清晰,易于学习与理解,下面请大家跟着小编的思路慢慢深入,一起来研究和学习“RDD的类型有哪些”吧!一、RDD定义 RDD(Resilient Distributed Datase

Spark RDD怎么创建

这篇文章主要介绍“ Spark RDD怎么创建”,在日常操作中,相信很多人在 Spark RDD怎么创建问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答” Spark RDD怎么创建”的疑惑有所帮助!接下来,请跟

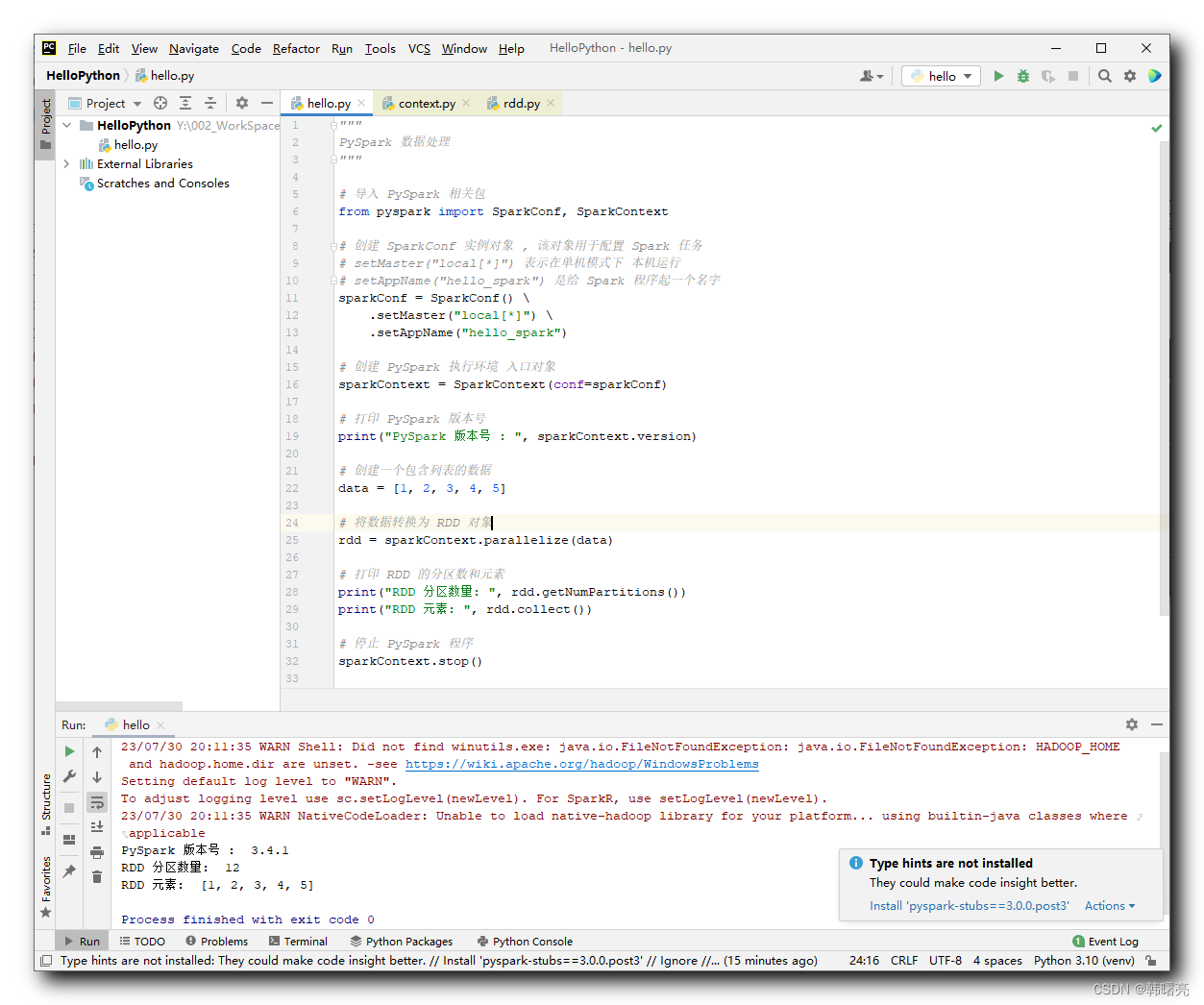

PySpark和RDD对象最新详解

Spark是一款分布式的计算框架,用于调度成百上千的服务器集群,计算TB、PB乃至EB级别的海量数据,PySpark是由Spark官方开发的Python语言第三方库,本文重点介绍PySpark和RDD对象,感兴趣的朋友一起看看吧

RDD的详解、创建及其操作

RDD的详解RDD:弹性分布式数据集,是Spark中最基本的数据抽象,用来表示分布式集合,支持分布式操作!RDD的创建RDD中的数据可以来源于2个地方:本地集合或外部数据源RDD操作分类转换算子Mapimport org.apache.spark.rdd.RD

创建RDD的方式有哪些

这篇文章主要讲解了“创建RDD的方式有哪些”,文中的讲解内容简单清晰,易于学习与理解,下面请大家跟着小编的思路慢慢深入,一起来研究和学习“创建RDD的方式有哪些”吧!1.从集合中创建RDD val conf = new SparkConf(

RDD和DataFrame和DataSet三者间的区别

在SparkSQL中Spark为我们提供了两个新的抽象,分别是DataFrame和DataSet。他们和RDD有什么区别呢?首先从版本的产生上来看:RDD (Spark1.0) —> Dataframe(Spark1.3) —> Dataset(Spark1.

PySpark中RDD的数据输出详解

这篇文章主要介绍了PySpark中RDD的数据输出详解,需要的朋友可以参考下

Spark SQL中的RDD与DataFrame转换实例用法

这篇文章主要讲解了“Spark SQL中的RDD与DataFrame转换实例用法”,文中的讲解内容简单清晰,易于学习与理解,下面请大家跟着小编的思路慢慢深入,一起来研究和学习“Spark SQL中的RDD与DataFrame转换实例用法”吧

Spark RDD常用算子是什么类型的

小编给大家分享一下Spark RDD常用算子是什么类型的,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!Spark RDD常用算子:Value类型Spark之所以比