分词

利用词云图分析热词

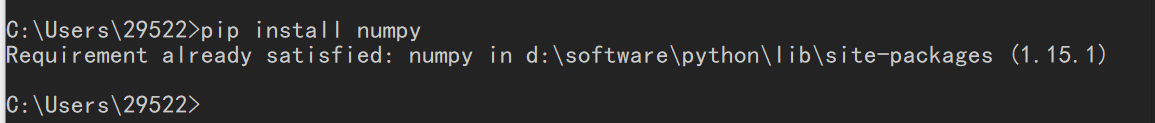

1.安装第三方库(matplotlib,jieba,wordcloud,numpy) 1.1安装方法:pip命令在线安装(python3.x默认安装了pip,pip下载地址:https://pypi.python.org/pypi/pip

python中文分词,使用结巴分词对python进行分词(实例讲解)

在采集美女站时,需要对关键词进行分词,最终采用的是python的结巴分词方法。 中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。 其基本实现原理有三点: 1.基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词

Python 英文分词

Python 英文分词,词倒排索引【一.一般多次查询】'''Created on 2015-11-18'''#encoding=utf-8# List Of English Stop Words# http://armandbrahaj.b

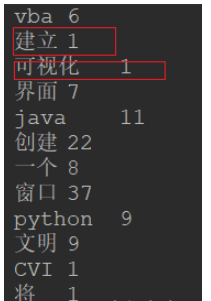

python中文分词和词频统计如何实现

这篇文章主要介绍“python中文分词和词频统计如何实现”,在日常操作中,相信很多人在python中文分词和词频统计如何实现问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”python中文分词和词频统计如何实现

python进行词性分析

表示python的nltk包真的很好用,本来想着自己从字典里面抓数据的,后来师兄建议用nltk包,http://www.nltk.org/install.html按照方法安装了包,接下来 import nltknltk.download()

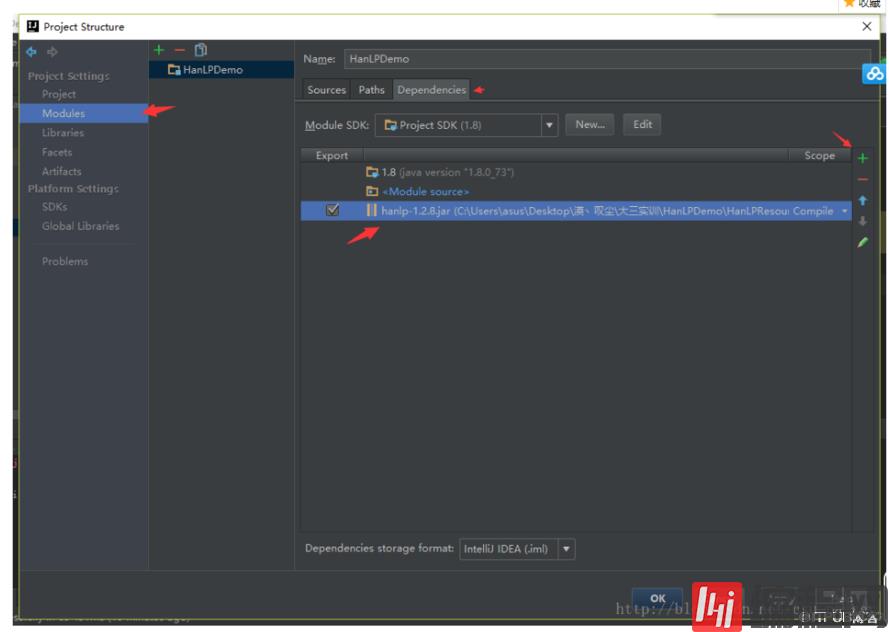

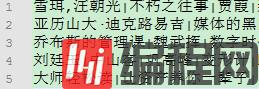

HanLP分词器的用法

本篇内容介绍了“HanLP分词器的用法”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成!前言:分析关键词如何在一段文本之中提取出相应的关键词呢?

Solr通过特殊字符分词实现自定义分词器详解

前言我们在对英文句子分词的时候,一般采用采用的分词器是WhiteSpaceTokenizerFactory,有一次因业务要求,需要根据某一个特殊字符(以逗号分词,以竖线分词)分词。感觉这种需求可能与WhiteSpaceTokenizerFa

Python jieba中文分词与词频统计的操作案例

这篇文章给大家分享的是有关Python jieba中文分词与词频统计的操作案例的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。Python主要用来做什么Python主要应用于:1、Web开发;2、数据科学研究;3、

Python分词工具有哪些

本篇内容介绍了“Python分词工具有哪些”的有关知识,在实际案例的操作过程中,不少人都会遇到这样的困境,接下来就让小编带领大家学习一下如何处理这些情况吧!希望大家仔细阅读,能够学有所成! 1、 jieba 分词 github地址:http

Python jieba分词怎么添加自定义词和去除不需要长尾词

这篇“Python jieba分词怎么添加自定义词和去除不需要长尾词”文章的知识点大部分人都不太理解,所以小编给大家总结了以下内容,内容详细,步骤清晰,具有一定的借鉴价值,希望大家阅读完这篇文章能有所收获,下面我们一起来看看这篇“Pytho

ElasticSearch 分词器,了解一下

这篇文章主要来介绍下什么是 Analysis ,什么是分词器,以及 ElasticSearch 自带的分词器是怎么工作的,最后会介绍下中文分词是怎么做的。首先来说下什么是 Analysis:什么是 Analysis?顾名思义,文本分析就是把全文本转换成一系列单

Xunsearch搜索的文本分析与分词器开发(如何为Xunsearch开发文本分析和分词器?)

Xunsearch搜索引擎中,文本分析与分词器负责将文本拆解成词语供索引和检索。开发分词器时需遵循以下步骤:了解文本分析和分词、选择分词算法、定义分词规则、构建分词器、评估分词器、集成到Xunsearch、优化分词器。常见用例包括全文检索、分面搜索、自然语言处理。最重要的是选择合适的算法、规则并定期优化分词器。